La virtualisation, qu'est-ce que c'est ?

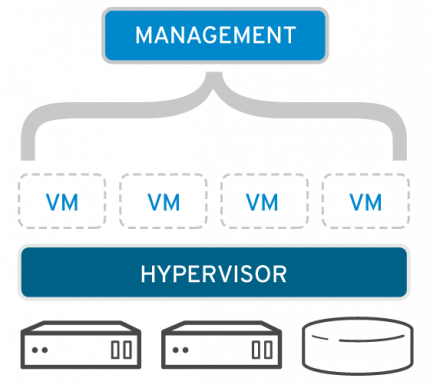

La virtualisation est une technologie qui vous permet de créer plusieurs environnements simulés ou ressources dédiées à partir d'un seul système physique. Son logiciel, appelé hyperviseur, est directement relié au matériel et vous permet de fragmenter ce système unique en plusieurs environnements sécurisés distincts. C'est ce que l'on appelle les machines virtuelles. Ces dernières exploitent la capacité de l'hyperviseur à séparer les ressources du matériel et à les distribuer convenablement. La virtualisation vous aide à tirer le meilleur parti de vos anciens investissements.

Le matériel physique doté d'un hyperviseur est appelé « hôte », tandis que toutes les machines virtuelles qui utilisent ses ressources sont appelées « invités ». Ces invités traitent les ressources de calcul (processeur, mémoire, stockage) à la manière d'un pool de ressources qui peut être déplacé sans difficulté. Les opérateurs peuvent contrôler les instances virtuelles du processeur, de la mémoire, du stockage et des autres ressources, de sorte que les invités reçoivent les ressources dont ils ont besoin, lorsqu'ils en ont besoin.

Migrez votre infrastructure virtuelle vers des solutions Red Hat

Quels sont les usages de la virtualisation ?

Virtualisation des fonctions réseau

Il est possible de créer des réseaux virtuels isolés à partir d'un seul réseau d'origine.

Virtualisation des serveurs

Un seul serveur peut fonctionner comme si vous en aviez deux, ou bien plus.

Virtualisation des systèmes d'exploitation

Un ordinateur peut exécuter plusieurs systèmes d'exploitation différents.

Quels sont les avantages de la virtualisation ?

La virtualisation permet aux administrateurs de rassembler leurs ressources physiques pour standardiser leur matériel. Par exemple, si vous disposez d'une infrastructure coûteuse mais capable de prendre en charge un grand nombre d'applications, vous pouvez l'optimiser en la virtualisant.

Les administrateurs ne sont plus obligés d'attendre que chaque application soit certifiée sur le nouveau matériel. Il leur suffit de configurer l'environnement et de migrer la machine virtuelle pour que tout fonctionne comme avant. Pendant les tests de régression, il est possible de créer ou copier un banc d'essai. Vous n'avez donc plus besoin d'y dédier un équipement particulier ou de conserver des serveurs de développement redondants. Et avec la bonne formation et les bonnes connaissances, vous pouvez optimiser ces environnements pour obtenir davantage de capacités et de densité.

La virtualisation est-elle sûre ?

Comme vous le savez, la sécurité doit être continue et intégrée. La virtualisation est une solution à de nombreux problèmes de sécurité fréquents. Dans les environnements dont les politiques de sécurité exigent la séparation des systèmes par un pare-feu, ces deux systèmes peuvent, sans risque, résider sur le même matériel. Dans un environnement de développement, chaque développeur peut aussi disposer de son propre environnement de test, à l'abri des codes non autorisés ou non contrôlés des autres développeurs.

Comment s'effectue la gestion des machines virtuelles ?

Comme son nom l'indique, le logiciel de gestion de la virtualisation facilite la gestion de la virtualisation. Vous pouvez parfaitement allouer manuellement des ressources aux machines virtuelles, leur faire de la place sur les serveurs, les tester et installer les correctifs le cas échéant. Mais dès que vous divisez un système unique en plusieurs centaines de systèmes, le volume de travail pour en assurer le bon fonctionnement, la mise à jour et la protection est multiplié d'autant.

Par contre, si toutes les machines virtuelles sont liées à un outil de surveillance, de provisionnement ou de gestion, il est possible de migrer les systèmes automatiquement sur un matériel plus adapté en cas de pic d'utilisation ou pendant les périodes de maintenance. Imaginez une ferme de serveurs qui peuvent être réalloués en quelques secondes selon la charge de travail et l'heure. Si une instance invitée se met à consommer plus de ressources que d'habitude, le système de surveillance la déplace sur un autre serveur moins sollicité ou lui alloue plus de ressources à partir d'un pool central.

Quelle est la différence entre la virtualisation et le cloud computing ?

Il est facile de les confondre, car il s'agit dans les deux cas de l'extraction des ressources du matériel pour créer un environnement utile. Bien que la virtualisation contribue à la création de clouds, elle ne peut pas être assimilée au cloud computing. Le principe est le suivant :

- La virtualisation est une technologie qui sépare les fonctions du matériel.

- Le cloud computing est une solution qui dépend de cette séparation.

Le NIST (National Institute of Standards and Technology) définit le cloud computing selon cinq caractéristiques : un réseau, des ressources regroupées en pools, une interface utilisateur, des fonctions de provisionnement ainsi que l'allocation et le contrôle automatiques des ressources. Si la virtualisation crée le réseau et les ressources du pool, il faut également un logiciel de gestion et un système d'exploitation pour créer une interface utilisateur, provisionner les machines virtuelles et contrôler/allouer les ressources.

La virtualisation et l'Open Source

Parce que la virtualisation n'est pas une fin en soi. Vous devez aussi réfléchir à ce qu'elle peut (ou ne peut pas) faire pour prendre en charge les technologies qui dépendent d'elle.

Les solutions de virtualisation propriétaires limitent l'accès au code source, c'est-à-dire à la clé qui vous permet de configurer votre infrastructure en fonction de vos besoins. Les utilisateurs de ce type de solutions sont souvent liés par des contrats de licence d'entreprise qui renforcent leur dépendance vis-à-vis des éditeurs de logiciels et réduisent leurs capacités à investir dans des technologies modernes telles que le cloud, les conteneurs ou les systèmes d'automatisation.

Les solutions de virtualisation Open Source, quant à elles, octroient aux utilisateurs un contrôle total sur l'infrastructure créée ainsi que sur tous les environnements qui en dépendent. En d'autres termes, vous pouvez la modifier pour travailler avec (ou sans) tel ou tel fournisseur. Et comme le code source vous appartient, pas besoin de contrat de licence pour le protéger.

VM et conteneurs : la différence

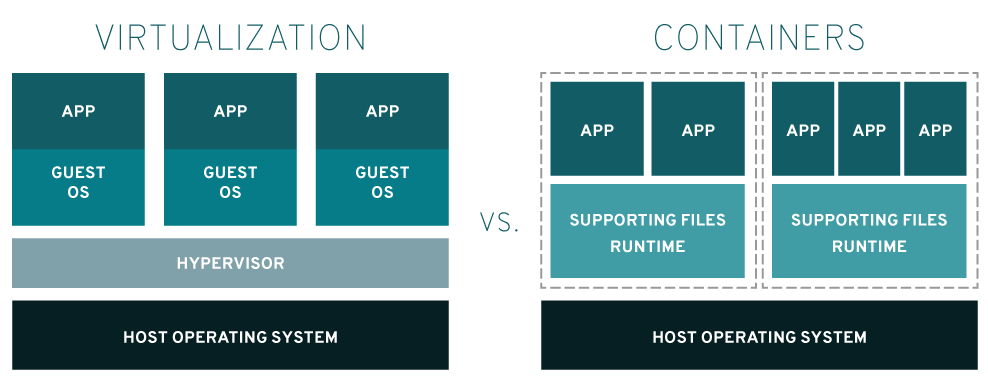

La virtualisation fournit les ressources que les conteneurs peuvent utiliser. Les machines virtuelles sont des environnements dans lesquels les conteneurs peuvent s'exécuter sans y être forcément liés. Certains logiciels, tels que Red Hat® OpenShift® Virtualization, permettent à la fois d'orchestrer des conteneurs et de gérer des machines virtuelles. Toutefois, cela ne signifie pas que ces deux technologies ne font qu'une.

Les machines virtuelles ont des capacités limitées, car les hyperviseurs qui les créent dépendent des ressources finies d'une machine physique. Les conteneurs, quant à eux, partagent le même noyau de système d'exploitation et mettent en paquet chaque application avec son environnement d'exécution de sorte que le paquet final peut être déplacé, ouvert et utilisé aussi bien en développement, qu'en test et en production.

Pourquoi choisir Red Hat pour la virtualisation ?

Parce que vous pouvez optimiser l'utilisation du matériel dont vous disposez en exécutant les systèmes auxquels vous êtes habitués sur l'une des infrastructures de virtualisation les plus puissantes au monde.

Nous soutenons le développement de la virtualisation depuis longtemps, en améliorant l'hyperviseur KVM (Kernel-based Virtual Machine) et en contribuant aux projets KVM et oVirt depuis la création de ces deux communautés. Chez Red Hat, nous utilisons nos propres produits pour accélérer l'innovation et faire en sorte que notre environnement d'exploitation soit plus agile et réactif.

Aujourd'hui, l'hyperviseur KVM est au cœur des principales solutions de virtualisation OpenStack® et Linux®. Il est aussi bien parti pour battre le record du nombre le plus élevé de machines virtuelles exécutées avec succès sur un seul et même serveur.

Bien sûr, toutes ces solutions sont Open Source, ce qui signifie qu'elles sont conçues pour tous types de matériel et ont été testées et certifiées sur ceux-ci. Nous avons aussi collaboré avec Microsoft, pour que vous puissiez déployer des machines virtuelles sous Red Hat® Enterprise Linux ou même gérer des centaines de machines virtuelles Windows à l'aide d'un seul produit de virtualisation.